https://www.anthropic.com/research/mapping-mind-language-model

Significant Breakthrough in AI Interpretability with Claude Sonnet

Researchers have made a groundbreaking advancement in AI by uncovering how millions of concepts are represented within Claude Sonnet, a state-of-the-art large language model. This marks the first detailed examination of the internal workings of such a model, potentially paving the way for safer AI.

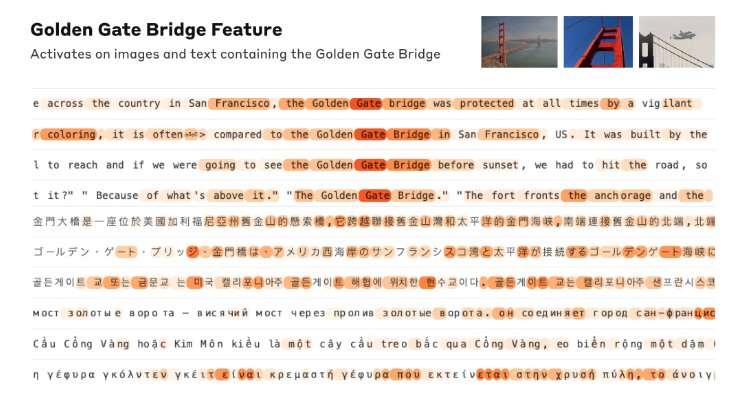

Traditionally treated as black boxes, AI models’ inner processes have remained mysterious, raising concerns about safety and reliability. Using a technique called “dictionary learning,” scientists were able to map internal states to human-interpretable concepts, revealing that each concept is spread across many neurons.

This breakthrough has significant implications for AI safety, as understanding and manipulating these internal features can alter the model’s behavior, potentially helping to mitigate biases and prevent misuse. The research, detailed in the paper “Scaling Monosemanticity: Extracting Interpretable Features from Claude 3 Sonnet,” opens new avenues for improving AI transparency and security.

Claude Sonnet에서 AI 해석 가능성에 대한 중요한 돌파구

연구자들이 최첨단 대형 언어 모델인 Claude Sonnet 내에서 수백만 개의 개념이 어떻게 표현되는지를 밝혀내며 AI 해석 가능성에 있어 획기적인 진전을 이루었습니다. 이는 이러한 모델의 내부 작동 방식을 처음으로 상세히 조사한 것으로, AI의 안전성을 높이는 데 중요한 전환점을 마련했습니다.

전통적으로 블랙박스로 취급되던 AI 모델의 내부 프로세스는 여전히 불투명해 안전성과 신뢰성에 대한 우려를 불러일으켰습니다. 연구진은 “사전 학습”이라는 기법을 사용해 내부 상태를 인간이 해석할 수 있는 개념으로 매핑하여 각 개념이 많은 뉴런에 걸쳐 분산되어 있음을 밝혀냈습니다.

이 발견은 AI 안전성에 중요한 의미를 지닙니다. 내부 특징을 이해하고 조작함으로써 모델의 행동을 변경할 수 있어 편향을 완화하고 오용을 방지하는 데 도움이 될 수 있습니다. 이번 연구는 “Scaling Monosemanticity: Extracting Interpretable Features from Claude 3 Sonnet” 논문에 자세히 나와 있으며, AI 투명성과 보안을 향상시키기 위한 새로운 길을 열었습니다.